Responsables : Sandrine ANTHOINE, Clothilde MELOT

Membres permanents : S. Anthoine, C. Mélot, F. Richard, K. Schneider, B. Torrésani.

Séminaire : Signal-Apprentissage. https://www.i2m.univ-amu.fr/seminaires_signal_apprentissage/

L’équipe SI est une composante du Groupe Scientifique Mathématiques de l’Aléatoire (ALEA).

On peut essayer de classifier les thèmes de l’équipe suivant les axes suivants :

Traitement du signal/image et apprentissage statistique

(Membres impliqués : S. Anthoine, C. Chaux, P. Escande, C. Mélot, F. Richard, K. Schneider)

L’équipe signal/image travaille depuis plusieurs années en étroite collaboration avec l’équipe d’apprentissage Qarma du LIS. Les collaborations d’abord centrées autour des problèmes d’optimisation parcimonieuse communs aux deux champs de recherche (par exemple l’étude d’algorithmes gloutons) se sont enrichies autour de thèmes tels que la complétion de données manquantes en audio ou l’apprentissage de représentations efficaces.

Par ailleurs, les membres de l’équipe travaillent aussi sur des problèmes d’apprentissage de familles d’opérateurs (par exemple en microscopie), mais aussi l’intégration de neurones profonds pour estimer des modèles de textures (c.f. la section « Analyse statistique de textures Browniennes »).

De plus, l’équipe s’attache à développer des méthodes numériques efficaces sur des problèmes de grandes dimensions. Ceci passe par une maîtrise complète de la chaîne de conception d’une méthode. C’est à dire de sa modélisation à son implémentation sur des architectures hautement parallèles, en passant par son étude théorique à l’aide d’outils de différents horizons tels que l’apprentissage de variétés, des inégalités de concentration, des méthodes d’optimisation non-convexe…

L’analyse, la modélisation et la simulation numérique de la turbulence fluide et plasma utilisant des techniques multi-échelles avec des applications en physique des plasmas, interaction fluide-structure et bio-fluides correspondent à une autre thématique de l’équipe. Le calcul scientifique à résolution extrême, sur superordinateur et GPU joue un rôle important. La consommation annuelle est de l’ordre de 25 000 000 h CPU sur IDRIS et le TGC du CEA. Pour le développement des codes et pour le stockage de données nous utilisons également le mésocentre à Marseille.

Pour l’analyse de la turbulence chargée des particules, calculée par simulation numérique directe à haute résolution, nous utilisons des techniques d’apprentissage machine, par exemple le DBscan, pour identifier les agrégats (cluster) de particules. Des méthodes de synthèse de champs d’écoulement turbulents artificiels et de distributions de particules inertielles basées sur le principe de l’entropie maximale sont mises au point. Des algorithmes de descente de gradient sont ensuite utilisés pour trouver un champ qui correspond à un ensemble de moments prédéfinis (c’est à-dire des statistiques d’ordre supérieur). Les transformées de diffusion d’ondelettes (scattering transform) en sont des éléments de base essentiels. Les résultats sont comparés aux données générées par les réseaux antagonistes générateurs (GAN).

Méthodes variationnelles et optimisation, problèmes inverses

(Membres impliqués : S. Anthoine, C. Chaux, P. Escande, K. Schneider)

Une approche classique de résolution de problème inverse est de définir une estimée de l’objet recherché comme le minimiseur d’un critère composite somme d’un terme d’attache aux données lié au modèle d’observation et de termes de régularisation ou contrainte renforçant certaines propriétés de l’objet cible. Une fois le critère formulé, des algorithmes itératifs (e.g. algorithmes proximaux, techniques de Majoration-Minimisation (MM), …) sont mis en oeuvre. Les domaines d’applications sont variés : reconstruction et restauration d’images biomédicales, restauration de données audio manquantes, démélanges de spectres, reconstruction des images obtenues par caméra rapide dans le tokamaks (dans le contexte de la fusion par confinement magnétique) par tomographie (avec régularisation ondelettes-vaguelettes) …

Modélisation probabiliste et statistique, traitement de données

(Membres impliqués : P. Escande, F. Richard, K. Schneider, B. Torrésani)

- Analyse statistique de textures Browniennes

Nous travaillons sur l’analyse statistique de propriétés de micro-textures irrégulières d’images pouvant être décrites au moyen d’extensions du modèle de champ Brownien fractionnaire. Les propriétés auxquelles nous nous intéressons sont principalement l’irrégularité, l’anisotropie et l’hétérogénéité. Nous avons recours à des modèles de champs Browniens mono- ou multi- fractionnaires anisotropes. Nous construisons des estimateurs permettant d’inférer ou de tester les propriétés de ces champs à partir d’une de leurs réalisations. Ces estimateurs sont principalement basés sur les incréments des champs et leurs variations quadratiques. Nous étudions leurs propriétés théoriques asymptotiques et leurs propriétés numériques. La méthodologie statistique est appliquée à toutes sortes de domaines (imagerie bio-médicale, conservation photographique, détection de défauts, …). Ces travaux se poursuivent actuellement par une approche bayésienne qui intègre la définition de réseaux de neurones profonds pour estimer les modèles. L’apprentissage de ces réseaux nécessite l’utilisation des ressources de calcul du mésocentre.

- Analyse statistique de surfaces aléatoires représentées par des courants

Nous travaillons sur l’analyse statistique de surfaces représentées par des modèles de courant. En nous inspirant de la théorie des processus généralisés, nous avons proposé une modélisation stochastique des surfaces en les plongeant dans un espace de formes linéaires aléatoires définies sur un espace de champs de vecteurs. Dans ce cadre, nous avons proposé des méthodes d’estimation de représentants moyens de populations de surfaces et de la variabilité des individus. Pour la discrétisation des estimateurs, nous nous sommes appuyés principalement sur des bases Hilbertiennes (Fourier, ondelettes, …) de l’espace des champs de vecteurs sur lequel sont définies les formes linéaires aléatoires. Nous avons étudié les propriétés asymptotiques de ces estimateurs. Les méthodes mises en place sont principalement appliquées à des surfaces extraites d’images cérébrales. Ces travaux se poursuivent par la mise en place de stratégie d’adaptation de la représentation aux données.

- Analyse et synthèse de processus localement stationnaires, séparation de sources non-stationnaires

Nous développons des algorithmes d’analyse de processus non stationnaires obtenus par déformation locale de processus stationnaires, la déformation étant approximée par une translation dans un domaine de représentation bien choisi (ondelettes, temps-fréquence, …). Les résultats les plus récents incluent une généralisation à l’analyse spectrale de classes de signaux non stationnaires multivariés (vue sous l’angle de la séparation de sources), et une approche de type synthèse qui nous paraît particulièrement prometteuse. Le domaine d’application principal est l’analyse de sons non-stationnaires, décrite plus loin.

- Outils d’analyse des transformations

Les transformations sont des objets qui apparaissent, souvent de manière implicite, dans des domaines variés comme le traitement des images, l’analyse de forme, en apprentissage statistique, … Ces transformations sont coûteuses à stocker, à appliquer et à interpréter de manière géométrique. Nous développons un panel d’outils permettant leur étude. Il repose sur une décomposition multi-échelle des transformations sur des dictionnaires de transformations élémentaires.

- Concentration des solutions de problèmes d’optimisation

Certaines méthodes de l’analyse statistique peuvent être formalisées comme cherchant à résoudre un problème d’optimisation sur une variété à partir d’un ensemble fini de données. Ces données résultent d’un processus d’échantillonnage aléatoire d’une mesure de probabilité sous-jacente. Nous étudions le comportement des solutions de ces problèmes d’optimisation.

- Analyse statistique multi-échelles pour les écoulements turbulents

Nous développons des outils statistiques pour l’analyse des écoulements turbulents qui permettent de quantifier les informations d’échelle, directionnelles et géométriques. Les applications portent sur les données d’écoulement turbulent, soit eulérien ou lagrangien, pour quantifier, par exemple, l’intermittence, l’hélicité dépendant de l’échelle et les angles de courbure ou de torsion dépendant de l’échelle.

Outils multirésolution (ondelettes, …), analyse temps-fréquence et approximation

(Membres impliqués : P. Escande, C. Mélot, K. Schneider, B. Torrésani)

- Analyse multirésolution sur les graphes à base de chaines de Markov

Les données sur des graphes ne permettent pas l’utilisation de certains outils classiques de traitement du signal, en particulier l’analyse multiéchelle par ondelettes. En effet les opérations de dilatation et de translation étant mal définies sur un graphe, les algorithmes classiques de décomposition multirésolution s’appliquent difficilement. Cependant un graphe pondéré étant naturellement associé à une chaine de Markov nous avons travaillé à mettre en place un algorithme de décomposition multiéchelle basé sur un schéma de décomposition du type filtrage-sous-échantillonnage, utilisant des outils probabilistes, pour le traitement du signal des données sur des graphes.

- Analyse multirésolution et bases d’ondelettes sur des surfaces

Motivés par des applications en neuroimagerie électromagnétique (EEG, MEG, SEEG) nous étudions de nouvelles constructions de bases d’ondelettes biorthogonales sur des surfaces (application visée : traitement de données sur les surfaces corticales). Nous avons développé une première construction basée sur le lifting scheme, que nous étudions et tentons d’améliorer. Les applications en problème inverse sont décrites plus loin.

- Analyse multifractale, régularité ponctuelle

L’analyse multifractale concerne l’étude de signaux dont la régularité ponctuelle varie de point en point. Nous travaillons sur différents critères de régularité ponctuelle (régularité ponctuelle pour des signaux non localement bornés, régularité anisotropique), et leur caractérisation à l’aide de coefficients sur des systèmes de type ondelettes, ainsi que sur des modèles sur lesquels il est possible de bien comprendre les liens entre différents exposants de régularité ponctuelle et les quantités globales qu’on peut chercher à calculer pour caractériser le signal.

L’étude de la décroissance des coefficients d’ondelettes permet d’analyser la régularité locale des champs d’écoulement turbulents et peut être utilisée pour détecter d’éventuelles singularités dans les écoulements, par exemple le taux de dissipation ou la reconnexion des couches de courant (reconnection of current sheets in MHD), calculés à haute résolution.

- Analyse temps-fréquence, principes d’incertitude

Nous développons des techniques de représentation et d’approximation de signaux dans le domaine conjoint temps-fréquence. Les principaux résultats concernent des techniques d’optimisation adaptative de fenêtre et réseau d’échantillonnage dans la transformation de Gabor, de décomposition de signaux en couches exploitant des concepts de parcimonie et parcimonie structurée (voir aussi Méthodes variationnelles et optimisation, problèmes inverses ci-dessus) et d’utilisation de la décomposition en modes empiriques pour le codage audio. Nous étudions aussi des bornes théoriques données par des inégalités d’incertitude de type inégalité de Heisenberg, Hirschman-Babenko-Beckner, Elad-Bruckstein ou Dembo-Maassen-Uffink dont nous avons obtenu des raffinements.

- Représentation d’opérateurs dans des trames temps-fréquence

Nous développons de nouvelles méthodes d’approximation d’opérateurs dans des trames, en particulier temps-fréquence et ondelettes. En particulier, nous avons obtenu des expressions explicites pour l’approximation optimale de certaines classes d’opérateurs par multiplicateurs temps-fréquence, exploitant des techniques liées à la théorie de Plancherel. Nous étudions également les problèmes d’estimation et d’identification d’opérateurs, dans un contexte d’analyse et transformation de signaux audio.

- Décomposition rapides des opérateurs

Les méthodes multi-résolution d’approximation des opérateurs ont donné lieu à des accélérations importantes des algorithmes, notamment en problème inverse. Cependant, ces méthodes reposent sur un changement de représentation des opérateurs. Cette étape a une complexité quadratique voire cubique par rapport à la discrétisation du problème. Ceci les rend inutilisables même pour des problèmes de moyenne dimension. Nous avons développé des méthodes de décomposition rapides en temps quasi-linéaires. A titre d’exemple, dans le cadre de la restauration d’image dégradées par des flous variables, un opérateur agissant sur des images de 16 millions de pixels se décompose en 4 ans sur un petit serveur de calcul. Nos méthodes permettent d’obtenir cette décomposition en seulement 4 heures.

- Méthodes numériques adaptatives pour EDP

Motivé par les écoulements fluides et plasmas en régime turbulent nous proposons une méthode semi-lagrangienne pour résoudre les équations d’Euler incompressibles sur une grille adaptative en temps et en espace. Cette nouvelle approche avance l’application de l’écoulement en temps avec une méthode de « gradient-augmented level set ». L’analyse multirésolution permet d’introduire une grille adaptative qui réduit la mémoire et le temps de calcul, en contrôlant la précision du schéma. Les géométries complexes sont traitées par une méthode de pénalisation. Nous effectuons des simulations numériques parallèles à très haute résolution pour étudier la structure multi-échelle de la turbulence.

Une deuxième approche est le développement d’un solveur adaptatif à base d’ondelettes pour les équations incompressibles de Navier-Stokes utilisant des grilles structurées en blocs. L’adaptabilité est introduite à l’aide d’ondelettes interpolatoires et le schéma de levage (lifting scheme) est appliqué pour obtenir une meilleure séparation d’échelle. Le code développé WABBIT (Wavelet Adaptive Block-Based solver for Interactions with Turbulence) est en accès libre et mis en œuvre sur des super-ordinateurs massivement parallèles. Des simulations d’écoulement d’insectes battants ont démontré son applicabilité à des problèmes complexes et bio-inspirés.

L’équipe travaille sur des données de différentes natures :

Signaux et images biomédicaux

(Membres impliqués : S. Anthoine, C. Chaux, P. Escande, F. Richard)

- Imagerie mammaire

Nous travaillons sur l’analyse des textures des images mammaires avec deux objectifs principaux, celui de détecter automatiquement des lésions présentes dans les images et celui d’évaluer un risque de développement du cancer avant son apparition. Les méthodes d’analyse que nous utilisons reposent sur une modélisation des images par des modèles de champs Browniens fractionnaires étendus.

- Tomographie à rayons X standard et spectrale

La tomographie à rayons X, ou tomodensitométrie, bénéficie ces dernières années d’une rupture technologique grâce aux détecteurs à rayons X de dernière génération développés au CPPM, les détecteurs à pixels hybrides. Ils permettent de travailler à très bas flux et de capturer de l’information énergétique sur l’objet imagé. Le premier volet de cette étude concerne les méthodes de reconstruction tomographique incorporant la nouvelle physique de détection et permettant de reconstruire à bas flux. Le problème inverse relatif modélise le bruit de Poisson, seul bruit inhérent à ce type de mesure ainsi que des a priori parcimonieux sur l’objet d’étude. Le second volet de cette étude concerne le développement d’une méthodologie afin de reconstruire l’objet d’étude et de cartographier ses principaux constituants d’intérêt à l’aide de l’information énergétique (i.e. spectrale) acquises par les détecteurs à pixels hybrides. Ce problème combine la reconstruction tomographique à la séparation de source dans un contexte non-linéaire.

- Imagerie biphoton

Nous travaillons sur la restauration d’images biphotoniques, modalité de microscopie par fluorescence qui possède de nombreux atouts, dont sa capacité à imager à de plus grandes profondeurs, à limiter la phototoxicité (ce qui permet d’effectuer des expériences in vivo), ainsi qu’à réduire le bruit d’acquisition.

Les différents expériences d’acquisitions montrent que la PSF (réponse impulsionnelle de l’instrument) est non stationnaire suivant l’axe Z (profondeur).

Le problème est formulé sur la forme d’un critère à minimiser (prenant en compte le modèle direct et des informations a priori) et des algorithmes d’optimisation (approches proximales, stratégie de Majoration-Minimisation (MM)) sont mis en œuvre afin de résoudre le problème d’optimisation.

- Imagerie à feuille de lumière

Tout comme l’imagerie biphoton, les modalités d’imagerie à feuille de lumière sont une microscopie par fluorescence. En revanche, la PSF varie ici dans les trois directions du volume. Cette spécificité donne lieu à des difficultés supplémentaires dans i) la restauration des images. Face à l’explosion des temps de calculs nous devons mettre au point de nouvelles méthodes permettant de les rendre utiles pour les biologistes, ii) l’identification de la PSF dans tout le champ de vue. En pratique, les dégradations de l’image sont induites par l’échantillon imagé et doivent donc être estimées. C’est un problème important qui nécessite le développement de méthodes efficaces dans l’estimation de grands jeux de données.

Signaux et images cérébraux

(Membres impliqués : C. Mélot, F. Richard, B. Torrésani)

- Imagerie cérébrale (neurosciences)

Nous travaillons sur la caractérisation des plissements corticaux à partir de surfaces extraites de l’imagerie cérébrale. Nous utilisons des outils représentations spectrales de graphes (Transformée de Fourier avec ou sans fenêtre, ondelettes, …). A partir de ces représentations, nous proposons des outils d’analyse des surfaces pour caractériser ou comparer des populations.

Un autre champ de recherche est celui de l’application de nouvelles méthodes d’analyse multirésolution basées sur la modélisation des données à l’aide de chaines de Markov. Nous comptons les appliquer à des problèmes de classification, segmentation, et analyse de régularité de données sur le cerveau.

- Problème inverse neuro-électromagnétique (EEG/MEG/SEEG) et applications en neurosciences cognitives

Nous développons de nouvelles approches pour le problème inverse EEG/MEG. Les deux caractéristiques principales des approches que nous développons sont la prise en compte précise de la dépendance temporelle des signaux cérébraux, et l’objectif d’obtenir des reconstructions de sources réellement quantitatives, contrairement aux cartes statistiques couramment utilisées. Les principaux ingrédients intervenant dans notre approche sont l’utilisation d’ondelettes (en temps, et plus original en espace, c’est à dire sur la surface corticale), l’utilisation de méthodes de maximum d’entropie conjuguées à des modèles de mélanges de gaussiennes, et des techniques de factorisation pour contrôler l’explosion dimensionnelle résultant de la modélisation spatiotemporelle.

- Modélisation statistique des signaux électrophysiologiques

Nous développons des modèles pour les signaux cérébraux et des algorithmes d’estimation et classification correspondants, notamment dans le cadre des interfaces cerveau-machine en collaboration avec le Laboratoire de Neurosciences Cognitives (LNC), l’équipe DYCOG du Centre de Recherche en Neurosciences de Lyon (CRNL) et le projet INRIA Athena.

Nous nous intéressons à la mise en œuvre de modèles intégrant des sources de variabilité diverses et à leur validation sur des données réelles. Les méthodes que nous développons combinent décomposition sur des bases Hilbertiennes (Ondelettes, Temps-fréquence, …) et modélisation statistique dans le domaine des coefficients (modèles mixtes, modèles de Markov cachés). Ceci se place dans le contexte de la caractérisation et discrimination de différents types d’ondes cérébrales.

Séparation de sources en spectroscopie (RMN, fluorescence)

(Membres impliqués : S. Anthoine, C. Chaux, F. Richard, B. Torrésani)

Dans le cadre de la spectroscopie RMN, on s’intéresse à des techniques de décompositions en matrices non négatives afin de faire du démélange de spectres. Dans le cas de la spectroscopie de fluorescence, on s’intéresse aux décompositions tensorielles non-négatives pour le démélange d’images.

Signaux audio-numériques

(Membres impliqués : C. Chaux, B. Torrésani)

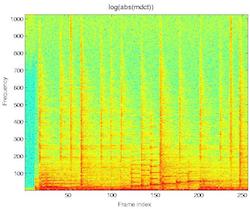

- Analyse et synthèse temps-fréquence de sons non-stationnaires

Dans le cadre d’applications audio, nous développons une approche originale d’analyse et synthèse de classes de processus aléatoires non stationnaires, modélisés comme déformations de processus stationnaires, comme décrit plus haut. En termes d’applications audio les modèles que nous développons se placent dans le cadre du paradigme « action-objet » développé par l’UMR PRISM, dans lequel une action non stationnaire est effectuée sur un objet dont la réponse linéaire est stationnaire. Parmi les applications émergentes, on peut notamment citer la synthèse de textures sonores, ou bruits d’environnement.

- Filtrage temps-fréquence (collaboration avec le LIS)

Nous développons une approche originale pour le filtrage temps-fréquence de signaux, en d’autres termes la modulation ou suppression de composantes non stationnaires dans les signaux dont les localisations temporelle et fréquentielle sont connues. L’approche repose sur une simple formulation variationnelle, dont une solution explicite fait intervenir des multiplicateurs temps-fréquence. Nous abordons les problèmes liés au fléau de la dimension par des techniques de projections aléatoires.

- Inpainting temps-fréquence

Un projet commun avec le LIS est de restaurer des données audio manquantes. Cette thématique d’« inpainting » a été plus largement étudié en image. L’objectif ici est de travailler dans le cadre général de l’inpainting audio pour des tâches impliquant des données audio manquantes (declipping, perte de paquets …).

Historique des responsables d’équipe :

- Caroline Chaux (2014/01/01-2022/08/31)

Dernière mise à jour : 21/07/2020